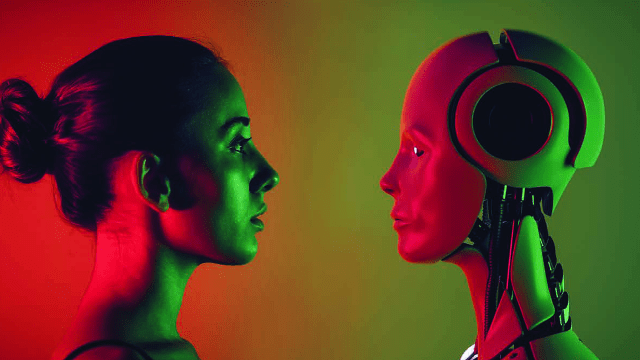

QUELLE EST LA CAPACITÉ DE L’HUMAIN À ABSORBER L’IA ?

Depuis l’émergence de ChatGPT, la presse généraliste s’est emparée du sujet de l’IA, rendue notoire par Open AI et autres services l’ayant mis à la portée d’un plus vaste public, et chacun y va de ses craintes et fantasmes. Il existe donc une starification de l’IA, l’IA coruscante, qui fascine autant qu’elle effraie. L’UE s’est saisie du sujet pour élaborer “l’AI Act” en juin 2023. Les études et articles regorgent d’exemples d’usages stupéfiants de l’IA. Face à cette déferlante d’innovations, comment l’humain peut-il accuser le coup ?

Par PHILIPPE KALOUSDIAN (P92), fondateur d’ISLEAN, cabinet de conseil en stratégie et transformation à l’ère du digital – philippe.kalousdian@mines-paris.org

Avec MATHILDE REGNIER-DULOUT et AMR ARBANI, managers chez ISLEAN

Dans les années 1990, le démineur de Windows (rappel qui fera sourire les plus anciens), jeu ringard ayant dévoré des millions d’heures de travail au bureau, avait une utilité peu connue : faire accepter au primate que nous sommes l’utilisation d’une souris et augmenter sa dextérité de déplacement de curseur et de clic. Les applications d’IA génératives telles ChatGPT ou Dall-E ont ce même rôle : nous faire accepter d’utiliser l’IA, sur un périmètre connu et sans risque : trouver des recettes de cuisine, élaborer un cocktail, produire du code informatique, etc.

Les technologies d’IA sont pourtant présentes dans de nombreux domaines depuis près de 10 ans, partout où il est nécessaire d’interpréter des signaux, d’une manière bien plus robuste qu’avec des règles explicites. Par exemple, la détermination de l’état d’une machine d’après ses vibrations ou autres signaux qu’elle émet, la compréhension par votre montre connectée que vous vous lavez les mains, la caractérisation de la nature d’une tumeur à partir d’une photographie, la traduction de phrases, la reconnais d’écriture typographique ou manuscrite…

- une première évolution, humaniste : le grand public s’empare de l’IA, qui, comme un exosquelette, devient un complément, un assistant, une orthèse mentale, et décuple nos capacités. Cela passe par de la formation, en école, et pas que dans les études supérieures ;

- une deuxième évolution, commerciale : des acteurs tels que Steve Jobs pour le Mac, et plus tard pour l’iPhone, assemblent technologies et design, rendent l’utilisation performante, facile et désirable, ce qui fait exploser les usages auprès du plus grand nombre ;

- a troisième évolution est sociétale : des usages aujourd’hui tabous des IA deviennent acceptables pour la majorité de la société, comme le sont devenus la fécondation in vitro, la chirurgie esthétique, les rencontres en ligne.

QUEL APPORT CONCRET DE L’IA À L’HUMAIN ?

Comme pour toutes les technologies, un gouffre va se creuser, et creuser les inégalités, les unes après les autres, entre ceux qui les fabriquent, ceux qui s’en emparent vite, ceux qui s’en emparent tard, et ceux qui n’en font rien. Au global, l’ensemble des gens finira par être tiré vers le haut, mais avec une période transitoire où on aura de grandes disparités, en espérant qu’elles se réduisent ensuite, par l’appropriation de masse.

Intéressons-nous plus particulièrement aux technologies de génération de texte. L’inconvénient de ces technologies est de donner l’illusion qu’elles sont intelligentes, de par leur capacité à donner l’impression de discourir avec vous de manière fluide et vraisemblable. Il ne faut pas s’y tromper : les générateurs de textes fonctionnent dans une pure logique de vraisemblance statistique, propre au jeu de données d’apprentissage. Ces systèmes sont incapables de raisonner, de comprendre le sens de leur propos, ou d’apporter des preuves ou des démonstrations. Ils sont juste capables d’apporter une réponse statistiquement probable d’après le jeu de données d’apprentissage. Et c’est déjà très bien !

Les personnes qui ne savent pas écrire sans fautes seront grandement aidées. Ceux qui ne savent rien sur un sujet auront un aperçu intéressant et bien formulé. Tous ceux qui savent écrire et, qui savent ce qu’ils ont envie de dire, n’auront pas besoin de ces IA génératives. Surtout si leurs propos s’éloignent de la moyenne du jeu de données d’apprentissage et représentent donc des « données aberrantes ». Les IA génératives sont un appauvrissement de la pensée et de la créativité, par construction. Elles ne sont, à ce stade, qu’un faux jumeau numérique de la réalité, bien loin de la richesse fractale du Meatspace1.

QUELLE CAPACITÉ DE L’HUMAIN À ÉVALUER L’IA ?

Comment évaluer qu’une IA est et reste plus performante que les humains ?

Comme rappelé plus haut, l’IA ne comprend pas, l’IA n’explique pas. Elle généralise. L’IA, en majorité, est un modèle bâti sur la base d’un jeu de données d’entraînement. Le modèle, sauf à avoir fait de l’hyper apprentissage2, est une simplification des données d’apprentissage, comme une courbe d’interpolation de degré n est une simplification du nuage de points à interpoler.

Comment évaluer si une IA reste performante ?

Prenons un exemple : une IA médicale est entraînée à détecter des mélanomes à partir de radios. Selon la méthode utilisée pour définir la « vérité », on peut obtenir une IA produisant des résultats strictement inférieurs à ceux d’un collège d’humains, ou une IA produisant des résultats potentiellement supérieurs à ce collège d’humains.

- Exemple 1 : des médecins se réunissent et évaluent des clichés de la peau pour déterminer si des mélanomes sont malins ou pas. La performance de la machine entraînée uniquement sur les diagnostics et non sur leur pertinence (qui ne pourra être vérifiée que plus tard) est nécessairement inférieure à 100 % puisqu’elle ne prend pas en compte la « réalité » de la maladie, mais plutôt l’interprétation des symptômes par des êtres humains ;

- Exemple 2 : on entraîne la machine à partir de photos suffisamment anciennes pour disposer du recul nécessaire et de la connaissance sur l’évolution du mélanome en cancer, ou pas. La performance de la machine est alors potentiellement supérieure à celle des médecins humains, l’algorithme étant supervisé et renforcé par la connaissance et l’intégration a posteriori des bons diagnostics.

Comment savoir, dans ce dernier cas, si la machine reste performante compte tenu de l’évolution du contexte ? Comment éviter le risque de fascination que génère la haute performance, et conserver un regard critique sur le fonctionnement de ces dispositifs ?

Cette capacité à ajuster les comportements des IA par évaluation humaine est de toute façon tributaire du travail des développeurs. Nous avons l’exemple de GPT-2 qui est devenu en une nuit « maximalement obscène » 3 parce qu’un développeur a supprimé un signe (-) par erreur, malgré les signalements des évaluateurs humains. Cette erreur a été repérée et corrigée, car elle a eu des conséquences visibles immédiates. Mais que se passerait-il si l’erreur était plus subtile, ou si elle avait des conséquences moins brusques ou moins évidentes ? Comment détecter, suffisamment tôt, que l’IA à laquelle on s’était habitué à faire une confiance aveugle est devenue, à bas bruit, partiellement ou tout à fait incompétente ?

Par exemple, si l’apparition d’un nouveau virus cutané génère des cancers de la peau, avec une évolution de la couleur des mélanomes qui n’existe pas dans le jeu de données d’apprentissage, combien de temps faudra-t-il pour détecter ce nouveau virus. Quel effort de conviction et de communication faudra-t-il déployer pour remettre en question l’Oracle MélanomeGPT ?

On peut objecter à cette crainte que les algorithmes d’apprentissage sont continûment affinés. Dans ce cas précis, ils peuvent être entraînés sur des images spectrométriques et non plus de simples clichés numériques, ce qui avec la détection de fluorescence par exemple améliore drastiquement la qualité du diagnostic.

DES BENCHMARKS PERMETTENT D’ÉVALUER UNE PARTIE DES MODÈLES

La plupart des applications de l’IA sont accompagnées de benchmarks développés par les scientifiques du domaine pour comparer la performance de modèles et d’humains sur des tâches précises. Ce sont ces benchmarks qui pour certains appuient et justifient d’ailleurs la publication de leur papier et de leur modèle. Pour en citer quelques-uns :

- General Language Understanding Evaluation (GLUE) pour la compréhension du langage naturel (https://bit.ly/Mines523-GLUE)

- ImageNET pour la classification depuis des images (https://bit.ly/Mines523-IN)

- LibriSpeech pour la transcription de voix (https://bit.ly/Mines523-LS)

Mais pour que les résultats soient fiables, il faut a minima que les modèles soient :

- Open source : sinon on ne sait pas ce qui a été inclus dans la structure du modèle qui pourrait affecter la neutralité du test ;

- Entraînés par celui qui les évalue : sinon rien ne garantit que les données du benchmark n’ont pas été utilisées pour entraîner le modèle, ce qui biaise le résultat.

Les IA ont une formidable capacité à détecter des patterns là où il n’existe pas de règles déterministes capables de traiter une quasi-infinité de cas possibles, phrases ou signaux divers, dès qu’ils ont été numérisés. Cette capacité s’exprime pleinement à partir du moment où il a été possible de disposer d’un jeu de données de référence ayant permis d’entraîner convenablement l’IA. Cependant, en attendant d’avoir simplifié l’usage des IA et d’avoir massivement formé à leur utilisation, pour permettre au plus grand nombre d’en tirer bénéfice, l’IA générera des inégalités profondes.

Au-delà de ces inégalités qui finiront par se réduire, se pose aussi la question de l’évaluation de la performance des IA dans la durée. Il ne faut pas céder à la facilité d’utiliser des IA pour s’éviter de théoriser des phénomènes déterministes. Si nous perdons cela de vue, c’est l’intelligence de l’humanité qui sera de plus en plus artificielle.

| PHILIPPE KALOUSDIAN (P92) Philippe est consultant dans le cabinet ISLEAN qu’il a fondé en 2008. Son métier consiste à mettre le progrès technologique à disposition des organisations et de leurs décideurs pour « Créer demain, maintenant. » Il a débuté comme ingénieur du cycle nucléaire à SGN devenu Orano. Il rejoint Bossard-Gemini consulting en 2000. Philippe est diplômé de Mines Paris - PSL, membre CA Mines Paris Alumni depuis 2008, et président depuis 2022, ainsi que membre fondateur de X-Mines Auteurs. Depuis 2014, il accompagne des start-up, dont Color Grail et AYO Lab. Il fait du ski et de la moto. Il connecte des univers lointains, ce qui souvent crée de la valeur par sérendipité. |

| MATHILDE REGNIER-DULOUT Mathilde est Ingénieure de l’École Centrale de Nantes et titulaire d’un Master Recherche (DEA) auprès du Laboratoire d’Automatique de Nantes, sur la « Normalisation de réseaux de communications de systèmes hétérogènes embarqués » pour le G.I.E. PSA-Renault. Elle est également titulaire d’un Master 2 en Management et Administration des Entreprises. Sa devise : Le conseil, c’est comme la chirurgie esthétique, si ça se voit, c’est que c’est mal fait. Elle est manager chez ISLEAN depuis septembre 2022. |

| AMR ARBANI Amr est un ingénieur en microtechnique, formé à Supélec puis à l’EPFL. Ses sujets de prédilection sont la robotique et la data science. Il pratique également le power-lifting et l’escalade à l’occasion. C’est avec une vocation d’accompagner dans le changement et l’innovation qu’il a rejoint ISLEAN consulting en 2019. Il a pu le faire au niveau de projets et de programmes de transformation, notamment dans le secteur pharmaceutique et avec les collectivités locales. |

Commentaires0

Veuillez vous connecter pour lire ou ajouter un commentaire

Articles suggérés