L’IA ET LA CONNAISSANCE : FORMATER LE RÉEL OU L’INVENTER ?

L’alliance des termes “intelligence” et “artificiel” entraîne une certaine perplexité. Si on délègue à l’artificiel des tâches qui pour nous relèvent de l’exercice de notre intelligence, l’outil les exécutant n’est-il pas alors aussi intelligent que nous ? A-t-on alors créé une intelligence ? Pourrait-elle être un concurrent ou un dépassement ? Ces questions potentiellement angoissantes sont pourtant sans réel objet.

Par BRUNO BACHIMONT (N82), philosophe et informaticien – bruno.bachimont@mines-nancy.org

L’efficacité calculatoire de l’IA n’est en rien de l’intelligence, mais, en revanche, les questions qu’on lui pose (ou qu’elle nous pose) révèlent la tension à laquelle notre intelligence est désormais soumise : une puissance de répétition bureaucratique ou procédurale normant nos comportements, ou une possibilité d’invention encore à explorer.

LA NOTION D’IA : UN CARREFOUR DE TRADITIONS DIVERSES

Si le terme a été forgé lors d’une célèbre école d’été au Dartmouth College en 1959, cette locution s’inscrit dans la lignée de deux traditions séculaires qui ont convergé progressivement : celle qui a consisté à voir la pensée comme du calcul, et celle qui a cherché à construire des machines qui calculent. L’idée que la pensée n’est après tout qu’une combinatoire de symboles, et que l’on peut la rapporter à du calcul exécuté sur des signes ou des nombres, remonte au moins au XIIIe siècle avec Raymond Lulle, moine catalan, qui, dans son ars magna, propose une combinatoire des vérités de la foi chrétienne. Cette idée est aussi exprimée en 1651 par Hobbes qui affirme que Reason is nothing but reckoning (Le Léviathan, V, 32). Idée également présente chez Leibniz à la fin du XVIIe siècle avec sa lingua characteristica universalis sur laquelle un calculus ratiocinator calcule et raisonne. Pour l’autre tradition, l’enjeu est de mécaniser le calcul ; de la célèbre Pascaline de Blaise Pascal en 1642 à la machine analytique de Charles Babbage (au XIXe siècle), même si ce dernier n’a pas pu la construire comme il l’entendait, en passant par Leibniz, toujours lui, on retrouve le projet de confier aux machines les tâches machinales, pas seulement celles articulant nos gestes, mobilisant notre force musculaire ou encore l’énergie, mais aussi les tâches intellectuelles répétitives comme compter et calculer.

Plus récemment, au XXe siècle, ces deux traditions ont convergé à travers les premières recherches qu’on a rassemblées sous le terme de “Cybernétique”. En effet, dans le contexte de la Seconde Guerre mondiale, la fondation Josiah Macy a réuni un cénacle interdisciplinaire de physiciens, mathématiciens, médecins, psychiatres, anthropologues, pour réfléchir sur les mécanismes de la pensée et leur modélisation. Deux articles firent date, tous deux de 1943 : le premier, Behavior, purpose and Teleology de A. Rosenbluth, N. Wiener and J. Bigelow, montrait comment un système fondé sur la rétroaction négative (le fait de prendre en compte l’action effectuée pour corriger la suivante – ce que fait une torpille qui corrige sa trajectoire pour se rapprocher de sa cible) pouvait simuler le fait d’avoir des buts et des intentions. Le second a logical calculus of the ideas immanent in nervous activity de W. McCulloch et W. Pitts montrait comment on pouvait considérer le cerveau comme une machine à calculer ayant la puissance d’un ordinateur (machine de Turing pour être précis) si on le voyait comme un assemblage de neurones formels (formalisation des neurones biologiques). L’histoire de l’IA moderne était alors amorcée : le premier article allait produire ce qu’on a appelé par la suite le contrôle des systèmes ou l’automatique, le second l’approche neuronale du calcul. D’ailleurs, le terme même de Cybernétique, proposé en 1948 par Wiener, vient du mot grec Kybernetes qui signifie gouvernail, pilote : la cybernétique est ce qui permet de contrôler un système. Wiener pensait qu’il y avait des principes communs dans le contrôle des systèmes vivants et artificiels : il avait été frappé par l’analogie entre les oscillations des systèmes de défense antiaérienne déficients et celles propres à certains troubles neurologiques. Il devait y avoir une théorie générale des systèmes qui transcende les différences entre vivant et mécanique, naturel et artificiel. Pour ce qui est de l’intelligence, comme le souligna John Haugeland, l’enjeu n’est donc pas de simuler ou d’approximer l’humain, mais de trouver les principes généraux de l’intelligence pour être capable de les répliquer sur des systèmes artificiels, ces derniers étant alors, selon cette approche, aussi intelligents que vous et moi.

L’INTELLIGENCE ARTIFICIEUSE

Mais, plutôt que de mécaniser un processus que l’on suppose avoir son siège dans la pensée ou dans le cerveau qui y serait sous-jacent, on peut se demander en quoi consiste effectivement l’activité de penser et de connaître. Or, si l’intelligence n’a pas toujours été artificielle, et ne le sera peut-être jamais, il semble en revanche qu’elle ait toujours été artificieuse. Autrement dit, pour s’exercer, l’intelligence se dote d’outils qui sont autant le fruit de ce qu’elle crée que la condition de sa mobilisation : pour penser, il faut des outils, et on pense d’autant mieux qu’on se construit des outils adaptés. L’exemple le plus évident d’un tel type d’outil est l’écriture : difficile d’exercer certaines tâches si on ne sait pas écrire, difficile de penser si on ne dispose pas d’un moyen matériel de projeter et d’inscrire son vouloir dire ou penser. L’inscription matérielle de nos pensées permet de les faire advenir (souvent, on se prend à penser au rythme de notre écriture) et évidemment d’y revenir : instrument de rétention, l’écriture retient l’événement du discours et de la pensée en un dispositif pérenne (même s’il est périssable) que l’on peut modifier à loisir, parcourir et relire selon un ordre, un rythme, une organisation laissés à l’entière discrétion du lecteur (rien de vous n’empêche de lire un roman policier en commençant par la fin, alors qu’il vous sera plus difficile d’écouter un discours – en direct, non enregistré – de cette manière). Les anciens l’avaient bien compris : scripta manent, verba volant.

Aussi ce qui compte n’est-il pas seulement la machine ou l’outil, mais l’alliance dialectique entre l’humain et ces derniers : la création d’artefacts (au sens littéral, le produit de l’art ou de la technique) permet la constitution de nouvelles intelligences ou modes de pensées et cela implique que c’est bien l’ensemble qui est un complexe cognitif développant de nouvelles connaissances. C’est donc le couplage entre l’humain et ses outils qui doit permettre de penser la co-construction des connaissances et la réalisation des performances cognitives associées. Mais les connaissances sont-elles les mêmes quand elles sont détenues par un humain ou représentées dans une machine ?

LES CONNAISSANCES ET LA MACHINE

Difficile de parler d’une notion comme celle de connaissance en quelques lignes. Aussi adopterons-nous un point de vue modeste et pragmatique : la connaissance est ce qui permet de réaliser une certaine tâche, d’obtenir un résultat ou d’atteindre un objectif, dans des situations données. La connaissance mathématique est ce qui permet de résoudre un problème ; la connaissance du menuisier de réaliser un meuble, etc. Mais derrière cette caractérisation d’apparence évidente et anodine, découlent quelques propriétés qui le sont moins. En effet, la connaissance est une disposition ou une capacité : ce qui permet d’atteindre un but. Ce n’est donc pas seulement ce qui se passe et ce qui est mobilisé lors de la réalisation de la tâche, mais c’est aussi ce qui reste ou se constitue entre deux tâches. La connaissance est cette décontextualisation qui permet de passer d’une tâche à une autre, ainsi que cette recontextualisation qui permet de traiter une nouvelle tâche. Une autre définition de la connaissance est alors l’expérience apprise ou sédimentée et qui est recontextualisée dans une nouvelle situation : c’est la pertinence de l’acquis dans un contexte nouveau.

Alors que le vivant s’adapte, l’artificiel répète. C’est ainsi que l’usine offre un environnement contrôlé pour le fonctionnement des machines et robots, qu’on formate les données pour y appliquer un algorithme, qu’on vérifie la nature des fichiers qu’on soumet à une application informatique.

Or, à ce stade de la réflexion, une différence importante s’établit entre les organismes vivants et les mécanismes artificiels. Alors que les premiers se constituent à partir de leur faculté d’adaptation (au niveau de l’organisme ou de sa lignée), les seconds se caractérisent par la répétition des mêmes processus de calcul. Aussi faut-il s’assurer par ailleurs que les situations rencontrées par ces derniers soient suffisamment contrôlées pour que le mécanisme de résolution puisse être répété et appliqué avec succès. Alors que le vivant s’adapte, l’artificiel répète. C’est ainsi que l’usine offre un environnement contrôlé pour le fonctionnement des machines et robots, qu’on formate les données pour y appliquer un algorithme, qu’on vérifie la nature des fichiers qu’on soumet à une application informatique. Autrement dit, nous ajustons le réel en fonction de nos connaissances, pour que la machine exerce la puissance de sa répétition calculatoire. Elle ne s’adapte pas à la situation, c’est cette dernière qui est adaptée ou contrôlée pour les besoins de la machine.

Mais cette limite posée à la machine, ou la séparation établie entre le vivant et le mécanique, ne sont sans doute pas si dirimantes que cela. En effet, pourquoi ne serait-il pas possible d’intégrer dans la capacité calculatoire de la machine la possibilité de sélectionner parmi les calculs appris et répétables ceux qui sont pertinents ? Au lieu d’avoir une adaptation au contexte, on aurait alors une sélection, c’est-à-dire la reconnaissance d’une situation déjà rencontrée, pour appliquer ensuite la répétition pertinente. Si les situations s’inscrivent dans un espace donné de représentation, on peut de même envisager d’interpoler entre des situations déjà rencontrées. L’adaptation à la situation est ainsi modélisée, voire expliquée, par la sélection, l’interpolation et enfin la répétition des mécanismes calculatoires.

L’IA CONTEMPORAINE ET LA CONTEXTUALISATION DES CONNAISSANCES L’IA

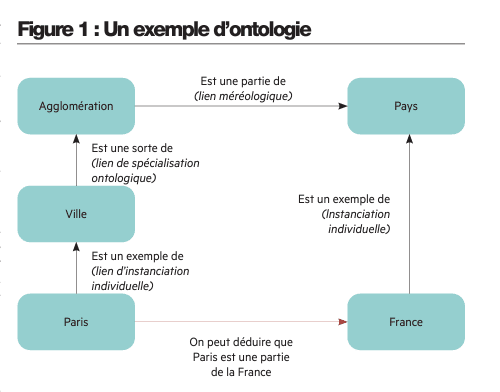

contemporaine se manifeste à travers deux facettes complémentaires : l’une que l’on peut appeler l’IA symbolique, qui se traduit par l’ingénierie des connaissances, telle qu’on peut la mettre en œuvre dans le Web des données, modélise les connaissances que les êtres humains possèdent et les exprime par des énoncés en langue naturelle ou des langues spécialisées. La représentation de ces connaissances est formalisée puis fournie à un système informatique pour effectuer des inférences et reproduire les raisonnements correspondant à la mise en œuvre de ces connaissances. Cette IA, si elle n’en possède pas toujours le nom, est très présente dans les systèmes d’information des entreprises : on a ainsi des ontologies, c’est-à-dire des vocabulaires structurés de concepts où l’on exprime les liens qui les unissent. Par exemple, dans Wikidata1, on aura des informations sur la ville de Paris, qui est un exemple de ville (relation d’instanciation), qui est une sous-catégorie de celle d’agglomération (relation ontologique de spécialisation) et une partie d’un pays (relation méréologique de composition). Les ontologies sont très utiles dans les domaines spécialisés, par exemple OGMS2 pour les connaissances médicales. Ces approches ont l’avantage important de pouvoir exploiter les connaissances dont on dispose dès lors qu’on les modélise formellement. L’inconvénient est par conséquent l’effort de formalisation qu’il convient de faire. Un autre inconvénient est la relativité de la modélisation : si deux modèles différents sont établis à partir d’un même domaine de connaissance, il sera difficile de les faire dialoguer.

Une autre IA est celle qui est la plus populaire aujourd’hui : on peut l’appeler l’IA numérique, ou encore l’IA statistique ou neuronale. C’est celle qu’on associe communément à l’apprentissage machine (machine learning - ML), pour insister sur un apprentissage guidé par des méthodes mathématiques et statistiques, ou à l’apprentissage profond (deep learning – DL) pour insister sur les méthodes fondées sur les réseaux de neurones ou des méthodes génératives (comme celles à la base de ChatGPT). Le principe est de disposer de données en nombre important, voire très important (plusieurs millions de textes, ou d’exemples) pour en abstraire un outil capable d’effectuer une tâche associée à ces données : reconnaître une forme, répondre à une question, etc. L’inconvénient de cette approche est double. D’une part, on ne peut pas “donner” à la machine les connaissances dont on dispose, il faut qu’elle les reconstruise à partir des données et exemples fournis. D’autre part, ces connaissances sont apprises et formalisées dans le modèle d’apprentissage via de nombreux paramètres qui déterminent son comportement (plusieurs milliards pour ChatGPT) : elles ne sont pas explicites. Aussi quand elles sont utilisées pour proposer des résultats, l’interprétation, la compréhension et la justification de ces derniers restent délicates et incertaines : c’est le fameux problème de l’explicabilité en IA. Mais l’avantage de ces approches, ce qui explique leur popularité, est de pouvoir s’adapter à toutes sortes de nouvelles données, comprises par interpolation (statistique, probabiliste, neuronale ou autre) et de proposer une solution. La masse des données utilisées pour l’apprentissage se retrouve dans la qualité des résultats fournis, mais au prix d’une certaine opacité interprétative du fonctionnement de l’outil et de biais liés au choix du corpus initial de données.

Une autre IA est celle qui est la plus populaire aujourd’hui : on peut l’appeler l’IA numérique, ou encore l’IA statistique ou neuronale. C’est celle qu’on associe communément à l’apprentissage machine (machine learning - ML), pour insister sur un apprentissage guidé par des méthodes mathématiques et statistiques, ou à l’apprentissage profond (deep learning – DL) pour insister sur les méthodes fondées sur les réseaux de neurones ou des méthodes génératives (comme celles à la base de ChatGPT). Le principe est de disposer de données en nombre important, voire très important (plusieurs millions de textes, ou d’exemples) pour en abstraire un outil capable d’effectuer une tâche associée à ces données : reconnaître une forme, répondre à une question, etc. L’inconvénient de cette approche est double. D’une part, on ne peut pas “donner” à la machine les connaissances dont on dispose, il faut qu’elle les reconstruise à partir des données et exemples fournis. D’autre part, ces connaissances sont apprises et formalisées dans le modèle d’apprentissage via de nombreux paramètres qui déterminent son comportement (plusieurs milliards pour ChatGPT) : elles ne sont pas explicites. Aussi quand elles sont utilisées pour proposer des résultats, l’interprétation, la compréhension et la justification de ces derniers restent délicates et incertaines : c’est le fameux problème de l’explicabilité en IA. Mais l’avantage de ces approches, ce qui explique leur popularité, est de pouvoir s’adapter à toutes sortes de nouvelles données, comprises par interpolation (statistique, probabiliste, neuronale ou autre) et de proposer une solution. La masse des données utilisées pour l’apprentissage se retrouve dans la qualité des résultats fournis, mais au prix d’une certaine opacité interprétative du fonctionnement de l’outil et de biais liés au choix du corpus initial de données.

CONNAISSANCE HUMAINE ET REPRÉSENTATION FORMALISÉE

Dans les deux cas, que la machine soit fondée sur des outils d’IA symbolique ou numérique, il est difficile de dire que la machine dispose de connaissances. Elle calcule plutôt sur des représentations ou encodage de ce qui est, pour des êtres humains, des connaissances. La connaissance formalisée exécutée par une machine n’est pas une connaissance, mais sa représentation, comme un homme peint sur un mur n’est pas un homme. Car dans les deux cas la machine ne traite que des situations représentées et encodées, déjà passées sous le crible de la formalisation par un utilisateur ou un concepteur. Elle n’est pas confrontée à la singularité d’une situation qu’il faut aborder dans sa nouveauté pour réviser éventuellement son mode de représentation. Au contraire, le vivant a cette capacité de s’adapter à des situations qui ne sont pas déjà identifiées et encodées, mais à construire et à découvrir. L’humain reconnaît une différence entre l’ici et le là-bas, le soi et l’autrui, différences qui structurent d’emblée son appréhension du réel. Une machine ne dispose que de données, c’est-à-dire ce qui lui est donné dans sa mémoire pour tenir compte de toutes sortes d’interprétations diverses. Mais toutes ses données sont ici, il n’y a pas de là-bas, et son appréhension du réel n’est pas gouvernée par la rencontre avec autrui ni avec un horizon qui se dévoile.

LES SUCCÈS DE L’IA : UN SYMPTÔME DE NOS SOCIÉTÉS OU UN NOUVEL HORIZON ?

Aussi la question que posent les IA n’est-elle pas ontologique : on ne crée pas des machines qui pensent. Elle n’est pas non plus cognitive : on ne dévoile pas une nature de la connaissance qui se retrouverait dans les mécanismes mis en œuvre en IA.

son intelligence apparente paraît d’autant plus remarquable que nous, les utilisateurs, nous sommes mis à son niveau et avons formaté nos réels, nos situations, nos usages, pour qu’ils soient adaptés à ce que la machine sait faire. Si la machine est une puissance de répétition, le fait anthropologique de l’IA est que nous réduisons nos possibles à cette puissance. Autrement dit, si la machine est capable de faire et répéter ce que nous faisons machinalement, elle sera d’autant plus efficace et efficiente que nos comportements seront réduits à ce qui est normé et répété. Le succès qu’on attribue aux outils issus des techniques appelées IA est en fait l’indice d’une normalisation de nos comportements et procédés et non de performances inouïes. L’inédit, le singulier, échappent à la machine, mais sans doute à nous aussi.

Mais, somme toute, il n’y a aucune nécessité pour ce que soit le cas. Les outils d’IA offrent des moyens inédits et nouveaux d’aborder et d’interroger le réel : s’il ne faut pas réduire le réel à ce que les algorithmes en font, il est évidemment pertinent, utile et passionnant de se lancer à la découverte des différentes réalités munis de tels outils : que ce soit le monde des arts (littérature, design, graphisme, etc.), mais aussi celui des sciences humaines, sociales, formelles ou naturelles, tous ces secteurs se voient en partie renouvelés par l’existence de ces outils. Apprendre à créer avec l’IA, à penser avec elle, c’est se donner les moyens d’acquérir de nouvelles connaissances que ces outils ne détiendront jamais par euxmêmes bien qu’ils en soient la condition essentielle.

| BRUNO BACHIMONT (N82) Professeur à l’université de technologie de Compiègne (UTC), Bruno Bachimont est docteur en informatique (Université de Paris 6), docteur en épistémologie (École Polytechnique) et a obtenu son Habilitation à Diriger des Recherches à l’UTC. Spécialisé dans les domaines de la logique, de l’informatique documentaire et de la philosophie du numérique, il a été directeur de la recherche de l’UTC de 2006 à 2017 puis directeur de la recherche et de la valorisation de la faculté des sciences et d’ingénierie de Sorbonne Université entre 2017 et 2021. Il a collaboré à l’INA comme directeur de la recherche puis comme conseiller scientifique de 1997 à 2012. |

Commentaires0

Veuillez vous connecter pour lire ou ajouter un commentaire

Articles suggérés